元のソース: 量子ビット

画像ソース: Unbounded AI によって生成

AppleのTransformerの「秘密」が愛好家によって明らかになりました。

大型モデルの波の中で、たとえAppleほど保守的であっても、記者会見のたびに「Transformer」について言及する必要がある。

たとえば、今年の WWDC で Apple は、iOS と macOS の新しいバージョンには、テキスト予測機能を備えた入力メソッドを提供する Transformer 言語モデルが組み込まれると発表しました。

Apple関係者はこれ以上の情報を明らかにしていないが、テクノロジー愛好家は黙ってはいられない。

Jack Cook という名前の人が macOS Sonoma ベータ版をひっくり返して、たくさんの新鮮な情報を発見しました。

さらに詳しく見てみましょう。

まず、Apple の Transformer ベースの言語モデルが iPhone、MacBook、その他のデバイスにどのような機能を実装できるかを確認してみましょう。

主に入力方法に反映されます。言語モデルによってサポートされている Apple 独自の入力方式により、単語予測と誤り訂正機能を実現できます。

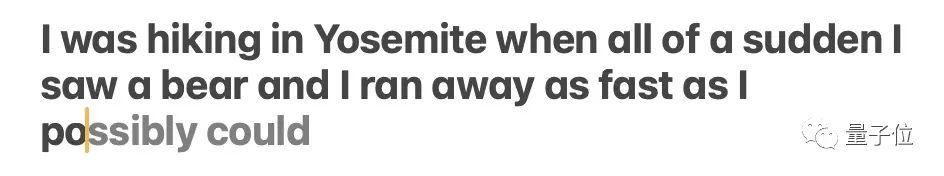

ジャック クック兄弟はこれを具体的にテストし、この関数が主に単一の単語の予測を実装していることを発見しました。

** **### △出典: ジャック クックのブログ投稿

このモデルは、今後の複数の単語を予測することがありますが、これは、Gmail のオートコンプリート機能と同様に、文の意味が非常に明白な状況に限定されます。

では、このモデルは一体どこに設置されているのでしょうか?徹底的に調査した結果、クック兄弟は次のように判断しました。

//Library/LinguisticData/RequiredAssets_en.bundle/AssetData/en.lm/unilm.bundle で予測テキスト モデルを見つけました。

なぜなら:

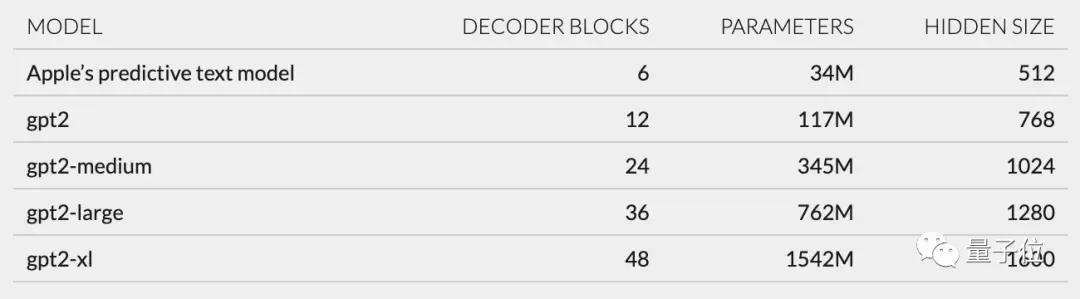

さらに、unilm_joint_cpu で説明されているネットワーク構造に基づいて、Apple モデルは GPT-2 アーキテクチャに基づいていると推測しました。

主にトークンの埋め込み、位置エンコーディング、デコーダー ブロック、出力層が含まれており、各デコーダー ブロックには gpt2_transformer_layer_3d のような単語が含まれます。

また、各層のサイズに基づいて、Apple モデルには約 3,400 万のパラメータがあり、隠れ層のサイズは 512 であると推測しました。つまり、GPT-2 の最小バージョンよりも小さいです。

これは主に、消費電力が少なく、高速かつ頻繁に実行できるモデルを Apple が望んでいるからだと思います。

WWDC での Apple の公式声明は、「キーがクリックされるたびに、iPhone はモデルを 1 回実行する」というものです。

ただし、これは、このテキスト予測モデルが文や段落を完全に継続するのがあまり得意ではないことも意味します。

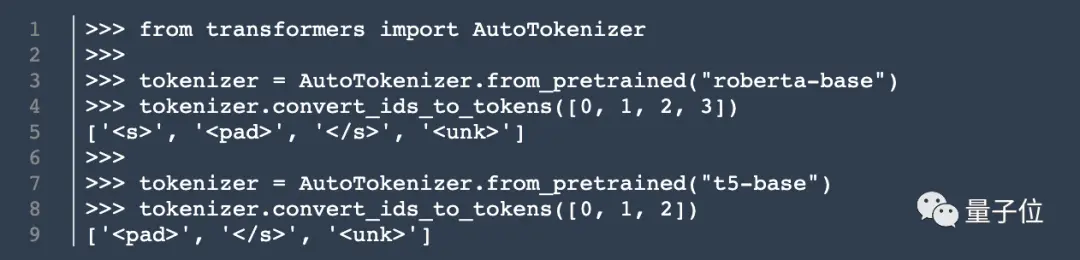

モデル アーキテクチャに加えて、Cook はトークナイザーに関する情報も調査しました。

彼は unilm.bundle/sp.dat で 15,000 個のトークンのセットを見つけました。これには 100 個の絵文字が含まれていることに注目してください。

このクックは料理人ではありませんが、私のブログ記事は公開されるやいなや、依然として多くの注目を集めました。

彼の発見に基づいて、ネチズンはユーザーエクスペリエンスと最先端のテクノロジーアプリケーションのバランスを取るためのAppleのアプローチについて熱心に議論しました。

ジャック・クック自身の話に戻りますが、彼はマサチューセッツ工科大学でコンピューター サイエンスの学士号と修士号を取得し、現在オックスフォード大学でインターネット社会科学の修士号取得に向けて勉強しています。

以前は NVIDIA でインターンとして、BERT などの言語モデルの研究に重点を置いていました。彼は、ニューヨーク タイムズ紙の自然言語処理の上級研究開発エンジニアでもあります。

それで、彼の啓示はあなたの中にいくつかの考えを引き起こしましたか?コメントエリアであなたの意見を共有することを歓迎します~

元のリンク:

9K 人気度

19.9K 人気度

42.5K 人気度

37.2K 人気度

2.2K 人気度

iPhone のトランスフォーマーを明らかに: GPT-2 アーキテクチャに基づいた単語セグメンターには、MIT 卒業生が作成した絵文字が含まれています

元のソース: 量子ビット

AppleのTransformerの「秘密」が愛好家によって明らかになりました。

大型モデルの波の中で、たとえAppleほど保守的であっても、記者会見のたびに「Transformer」について言及する必要がある。

たとえば、今年の WWDC で Apple は、iOS と macOS の新しいバージョンには、テキスト予測機能を備えた入力メソッドを提供する Transformer 言語モデルが組み込まれると発表しました。

Jack Cook という名前の人が macOS Sonoma ベータ版をひっくり返して、たくさんの新鮮な情報を発見しました。

さらに詳しく見てみましょう。

GPT-2 アーキテクチャに基づく

まず、Apple の Transformer ベースの言語モデルが iPhone、MacBook、その他のデバイスにどのような機能を実装できるかを確認してみましょう。

主に入力方法に反映されます。言語モデルによってサポートされている Apple 独自の入力方式により、単語予測と誤り訂正機能を実現できます。

** **### △出典: ジャック クックのブログ投稿

**### △出典: ジャック クックのブログ投稿

このモデルは、今後の複数の単語を予測することがありますが、これは、Gmail のオートコンプリート機能と同様に、文の意味が非常に明白な状況に限定されます。

** **### △出典: ジャック クックのブログ投稿

**### △出典: ジャック クックのブログ投稿

では、このモデルは一体どこに設置されているのでしょうか?徹底的に調査した結果、クック兄弟は次のように判断しました。

なぜなら:

さらに、unilm_joint_cpu で説明されているネットワーク構造に基づいて、Apple モデルは GPT-2 アーキテクチャに基づいていると推測しました。

主にトークンの埋め込み、位置エンコーディング、デコーダー ブロック、出力層が含まれており、各デコーダー ブロックには gpt2_transformer_layer_3d のような単語が含まれます。

** **### △出典: ジャック クックのブログ投稿

**### △出典: ジャック クックのブログ投稿

また、各層のサイズに基づいて、Apple モデルには約 3,400 万のパラメータがあり、隠れ層のサイズは 512 であると推測しました。つまり、GPT-2 の最小バージョンよりも小さいです。

これは主に、消費電力が少なく、高速かつ頻繁に実行できるモデルを Apple が望んでいるからだと思います。

WWDC での Apple の公式声明は、「キーがクリックされるたびに、iPhone はモデルを 1 回実行する」というものです。

ただし、これは、このテキスト予測モデルが文や段落を完全に継続するのがあまり得意ではないことも意味します。

** **### △出典: ジャック クックのブログ投稿

**### △出典: ジャック クックのブログ投稿

モデル アーキテクチャに加えて、Cook はトークナイザーに関する情報も調査しました。

彼は unilm.bundle/sp.dat で 15,000 個のトークンのセットを見つけました。これには 100 個の絵文字が含まれていることに注目してください。

クックがクックを明かす

このクックは料理人ではありませんが、私のブログ記事は公開されるやいなや、依然として多くの注目を集めました。

以前は NVIDIA でインターンとして、BERT などの言語モデルの研究に重点を置いていました。彼は、ニューヨーク タイムズ紙の自然言語処理の上級研究開発エンジニアでもあります。

それで、彼の啓示はあなたの中にいくつかの考えを引き起こしましたか?コメントエリアであなたの意見を共有することを歓迎します~

元のリンク: